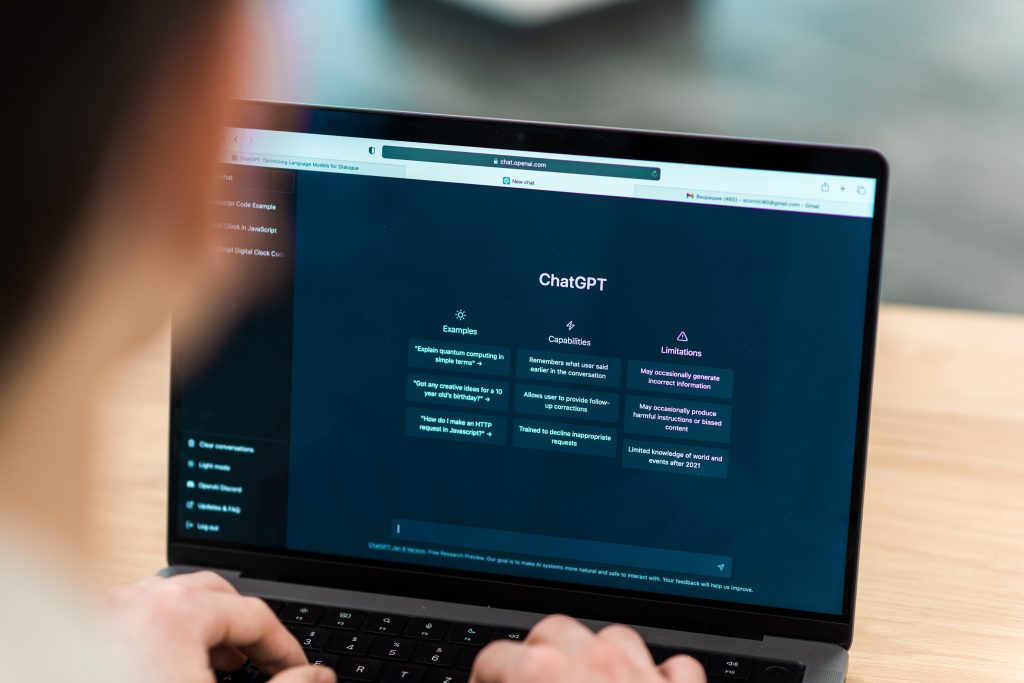

如今,人工智能(AI)已經滲透到我們生活的方方面面,ChatGPT、Sanpchat的My AI Snaps等人工智能應用備受關注。 生成預訓練 Transformer (GPT) 是一種深度學習模型,使用大規模神經網絡生成自然語言文本。 GPT 基於 Transformer 架構,由多層自註意力和前饋模塊組成。 GPT 可以從大量未標記的文本數據中學習,然後對特定任務進行微調,例如文本摘要、機器翻譯、問答等。

GPT 的主要目標之一是實現通用人工智能 (AGI),即機器執行人類可以完成的任何智力任務的能力。 為此,GPT 旨在捕捉自然語言文本中隱含的常識知識和推理技能。 GPT 還致力於生成連貫且多樣化的文本,以滿足各種用戶意圖和偏好。

GPT的主要功能和挑戰

• AGI-GC:AGI-GC 代表通過生成膠囊的通用人工智能,它是 OpenAI 提出的使用生成模型實現 AGI 的框架。 AGI-GC 表明,生成模型可以通過以分層方式組合更簡單的概念來學習表示和操作複雜的概念。 生成膠囊是該框架的構建塊,它們是可以在潛在空間中生成和編碼信息的神經模塊。

• 模型參數:模型參數是指GPT 模型的大小和復雜性,其神經網絡中可以有數十億個可訓練參數。 例如,GPT 的最新版本 GPT-3 擁有 1750 億個參數,使其成為有史以來創建的最大的模型之一。 數十億級參數給GPT模型的訓練、推理和部署帶來了計算成本、內存消耗、可擴展性和魯棒性等挑戰。

• 大型語言模型(LLM):大型模型是一種人工智能算法,可以使用具有大量參數的神經網絡技術來處理和理解人類語言或文本1。 大型模型通常基於大量文本數據進行訓練,這些文本數據大部分來自互聯網2。 大型模型可以執行各種任務,例如識別、總結、翻譯、預測和生成文本及其他形式的內容。

• 泛化:泛化是指模型在接受有限或特定數據或任務集的訓練後,在未見過的或新的數據或任務上表現良好的能力。 泛化是 GPT 模型的一個重要目標,因為它表明了它們的適應性和魯棒性。 通過使用大型且多樣化的數據集進行預訓練,以及使用有效的方法進行微調或遷移學習,可以實現泛化。

• 強化學習:強化學習(RL) 是一種機器學習範例,涉及基於獎勵和懲罰的試錯學習。 RL 可用於訓練 GPT 生成優化某些目標或指標的文本,例如流暢性、相關性、多樣性或用戶滿意度。 強化學習還可用於探索文本生成的不同策略或策略,例如採樣方法、解碼算法或溫度參數。

• RLHF:RLHF 代表人類反饋強化學習,這是一種通過結合人類判斷來提高 GPT 生成文本的質量和多樣性的方法。 RLHF 涉及收集對生成文本的人類反饋,例如評級、偏好或更正,然後將它們用作訓練模型的獎勵或懲罰。 RLHF 可以幫助 GPT 了解人類的偏好和期望,並避免生成有害或不適當的文本。

• 湧現:湧現是指簡單的交互或規則產生復雜的模式或行為的現象。 出現可以在自然語言文本中觀察到,其中含義和結構是從單詞和句子的組合中出現的。 GPT 生成的文本中也可以觀察到湧現,其中新穎或創造性的文本是從標記和層的組合中出現的。 出現對於 GPT 模型來說是有益的,因為它可以增強其表現力和多樣性。

• 微調:微調是一種通過使用少量標記數據更新其參數來使預訓練模型適應特定任務或領域的方法。 微調可以幫助 GPT 模型在下游任務或需要專門化的領域上表現更好。

GPT可以協助您提高業務效率並提供各種好處

• 自動執行例行任務,例如內容創建、數據分析、文檔生成等。

• 通過生成自然且有吸引力的響應、提供個性化建議以及提供多語言支持,有效地了解客戶並與客戶溝通。

• 通過生成摘要、報告、反饋和建議來簡化項目管理、知識共享、培訓和協作等內部流程。

• 通過生成可視化、解釋、預測和場景,從大型且複雜的數據源中獲得有價值的見解15。

金蝶雲蒼穹GPT 盛大發佈

8月8日,金蝶在深圳舉辦“2023全球創作者大會”,慶祝金蝶成立30週年。 會議期間,金蝶發布了百億參數的CosmicGPT大模型。 CosmicGPT大模型基於通用大模型的持續預訓練,定位為懂管理的企業級大模型平台。